En celebración de su 25.º aniversario, revisamos los logros más destacados de Google en materia de inteligencia artificial (IA) hasta la fecha, vislumbrando un futuro prometedor en este campo.

La IA en Google: un trayecto de relevancia continua

La IA ha ganado importancia recientemente, pero en Google, siempre ha sido un tema de gran relevancia desde sus inicios, y por buenas razones. La IA tiene el potencial de simplificar tareas cotidianas y abordar los desafíos más apremiantes de la sociedad. En el marco de la celebración de su 25.º aniversario, repasemos algunos de los hitos más notables en la trayectoria de la IA hasta ahora.

2001: Corrección de ortografía en búsquedas de Google mediante aprendizaje automático

El cofundador de Google, Larry Page, expresó alguna vez que "el motor de búsqueda perfecto debería entender exactamente lo que deseas expresar y entregarte precisamente lo que necesitas". Un gran avance hacia esta visión se logró al implementar una versión inicial de aprendizaje automático que sugería correcciones ortográficas en las búsquedas web. Incluso si la escritura no es perfecta, aun así, Google puede proporcionar lo que el usuario necesita.

2006: Lanzamiento de Google Translate

Cinco años después, se lanzó Google Translate, utilizando aprendizaje automático para traducir idiomas de forma automática. Inicialmente, se traducían idiomas árabe-inglés e inglés-árabe. En la actualidad, Google Translate admite 133 idiomas hablados por millones de personas en todo el mundo. Esta tecnología puede traducir texto, imágenes o incluso conversaciones en tiempo real, eliminando las barreras lingüísticas a nivel global y facilitando la comunicación y el acceso a la información como nunca antes.

2015: TensorFlow democratiza la IA

La introducción de TensorFlow, un marco de aprendizaje automático de código abierto, democratizó el acceso a la IA, haciéndola más accesible, escalable y eficiente. También aceleró la investigación y el desarrollo de la IA a nivel mundial. TensorFlow se ha convertido en uno de los marcos de aprendizaje automático más populares y se ha utilizado para desarrollar una amplia gama de aplicaciones de IA, desde reconocimiento de imágenes hasta procesamiento del lenguaje natural y traducción automática.

2016: AlphaGo vence al Campeón Mundial de Go

Como parte del Google DeepMind Challenge Match, más de 200 millones de personas vieron en línea cómo AlphaGo se convirtió en el primer programa de IA en vencer a un campeón mundial humano en Go, un juego de mesa complejo que se consideraba inalcanzable para las máquinas. Esta victoria histórica demostró el potencial del aprendizaje profundo para resolver problemas complejos que antes se consideraban imposibles para las computadoras. La victoria de AlphaGo sobre Lee Sedol, uno de los mejores jugadores de Go del mundo, generó un debate global sobre el futuro de la IA y demostró que los sistemas de IA ahora pueden aprender a dominar juegos complejos que requieren pensamiento estratégico y creatividad.

2016: Unidades de procesamiento tensorial (TPUs) para una implementación de IA más rápida y eficiente

Las Unidades de Procesamiento Tensorial (TPUs) son chips de silicio diseñados a medida específicamente para el aprendizaje automático y optimizados para TensorFlow. Estos chips pueden entrenar y ejecutar modelos de IA mucho más rápido que los chips tradicionales, lo que los convierte en la elección ideal para aplicaciones de IA a gran escala. La versión v5e, anunciada en agosto, es la TPU en la nube más rentable, versátil y escalable hasta la fecha.

2017: Transformer de Google Research mejora la comprensión del lenguaje

El artículo de investigación de Google Research "Attention Is All You Need" presentó el Transformer, una nueva arquitectura de red neuronal que mejoró significativamente la comprensión del lenguaje. Antes de Transformer, las máquinas no eran eficientes para entender el significado de oraciones extensas, ya que no podían percibir las relaciones entre palabras distantes. Transformer superó esta limitación y se ha convertido en la base de los sistemas de inteligencia artificial generativa y comprensión del lenguaje más impresionantes de la actualidad. Ha revolucionado la forma en que las máquinas traducen, resumen textos, responden preguntas e incluso generan imágenes y se aplican en la robótica.

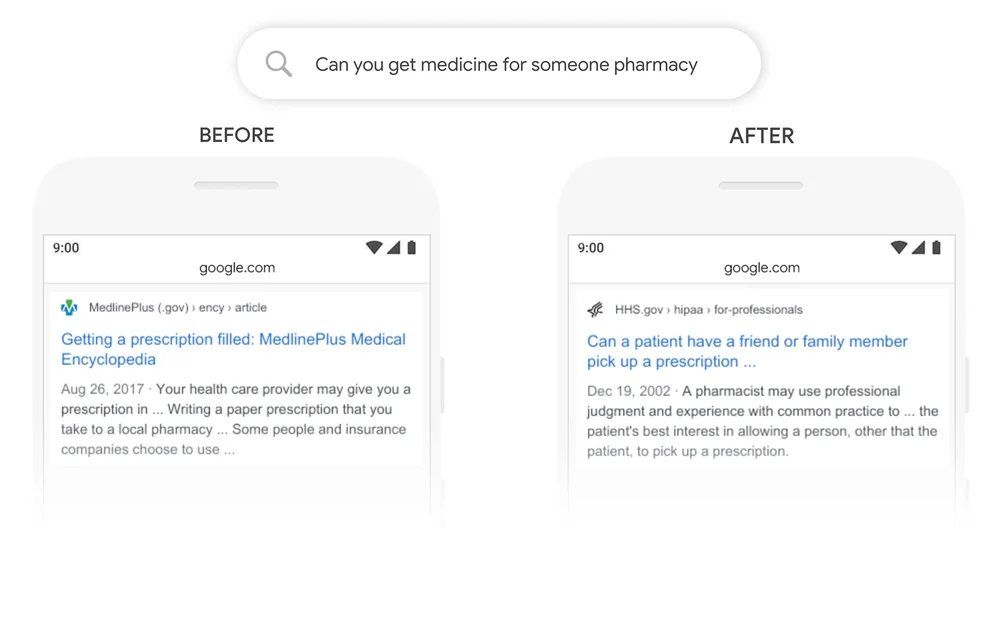

2019: BERT mejora la comprensión de consultas en la búsqueda

La investigación sobre Transformers llevó a la introducción de «Bidirectional Encoder Representations from Transformers» (BERT), una técnica que mejoró la comprensión de las consultas de los usuarios por parte de la Búsqueda. En lugar de abordar las palabras individualmente, los algoritmos BERT permitieron a Google entender las palabras en contexto. Esto dio como resultado una mejora significativa en la calidad de la Búsqueda y facilitó que las personas formularan preguntas de manera natural, en lugar de depender de palabras clave.

2020: AlphaFold resuelve el problema del plegamiento de proteínas

En 2020, DeepMind logró un avance significativo en el campo de la IA con AlphaFold, un sistema reconocido por resolver el «problema del plegamiento de proteínas». Dado que las proteínas son fundamentales para la vida, su plegamiento determina su función; una proteína mal plegada puede ocasionar enfermedades. Durante 50 años, los científicos habían intentado predecir cómo se plegaría una proteína para comprender y tratar enfermedades. AlphaFold logró precisamente eso.

Posteriormente, en 2022, se compartieron 200 millones de estructuras de proteínas de AlphaFold, abarcando casi todos los organismos cuyos genomas han sido secuenciados. Estas estructuras están disponibles libremente para la comunidad científica a través de la base de datos de estructuras de proteínas de AlphaFold. Más de 1 millón de investigadores ya han utilizado esta información para avanzar en diversas áreas, desde acelerar nuevas vacunas contra la malaria en tiempo récord hasta impulsar el descubrimiento de fármacos contra el cáncer y desarrollar enzimas que descomponen el plástico.

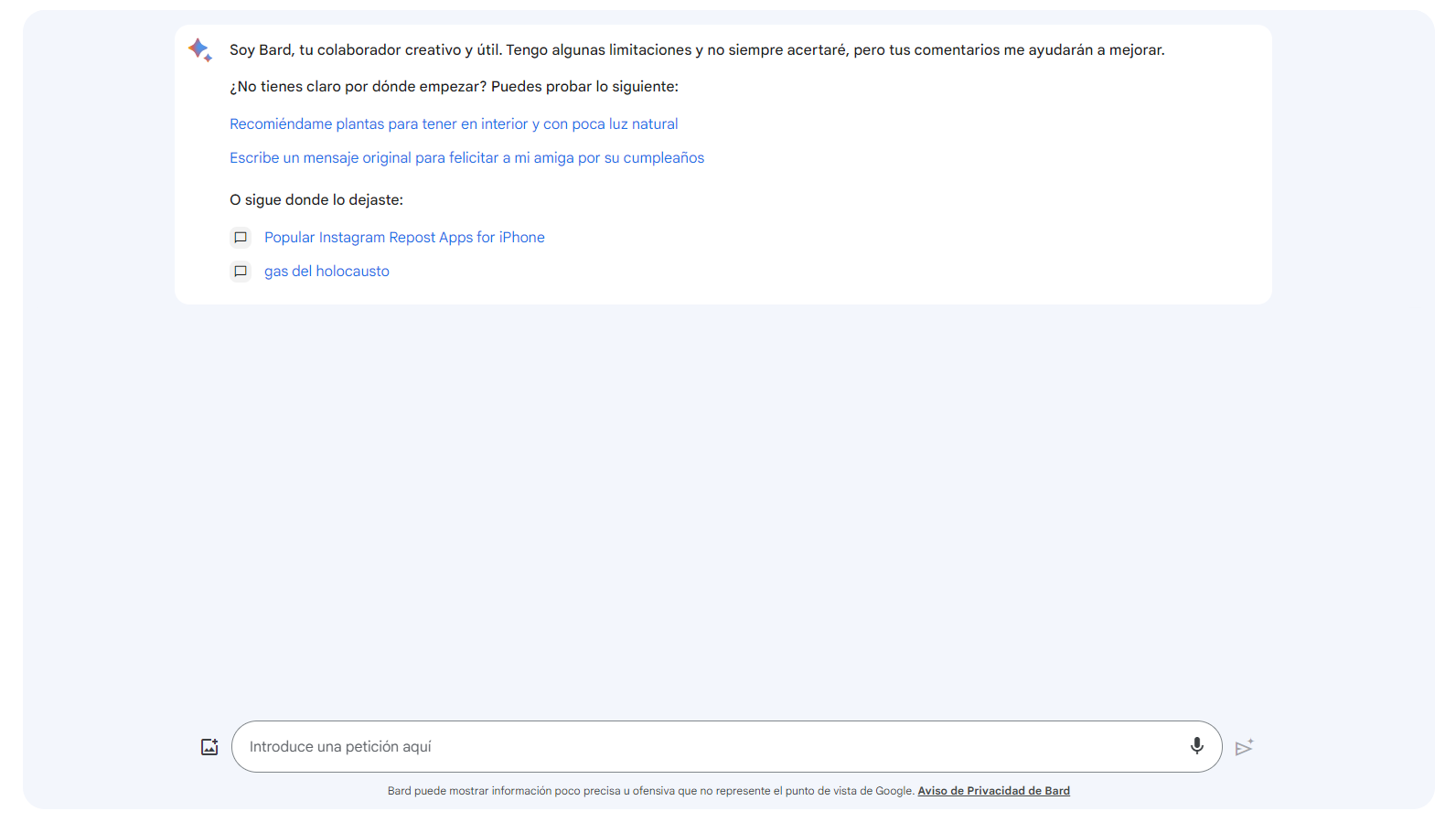

2023: Bard facilita la colaboración con IA generativa

En marzo de este año, Google Research lanzó LaMDA, un modelo de lenguaje de gran envergadura conversacional, allanando el camino para muchos sistemas de IA generativa que han capturado la imaginación del mundo, incluido Bard. Este último, ahora disponible en la mayor parte del mundo y en más de 40 idiomas, permite a más personas que nunca utilizarlo para aumentar la productividad, acelerar las ideas y fomentar la curiosidad. Combina el modelo más inteligente y capaz de Bard con los servicios de Google que se usan cotidianamente, como Gmail, Docs, Drive, Vuelos/Hoteles, Maps y YouTube, para hacerlo aún más útil en tareas como planificación de viajes, verificación de respuestas y resumen de correos electrónicos o documentos.

2023: PaLM 2 impulsa el futuro de la IA

En mayo, se presentó PaLM 2, el modelo de lenguaje de gran envergadura de próxima generación de Google. Este modelo mejora las capacidades multilingües, de razonamiento y de codificación. Es más capaz, rápido y eficiente que sus predecesores y ya impulsa más de 25 productos y funciones de Google, incluyendo Bard, funciones de IA generativa en Gmail y Workspace, y SGE, un experimento para integrar profundamente la IA generativa en la Búsqueda de Google. Además, se está utilizando PaLM 2 para avanzar en la investigación interna en diversas áreas, desde atención médica hasta ciberseguridad.

Estos hitos en inteligencia artificial reflejan el compromiso de Google con la innovación y la creación de soluciones que impactan positivamente en la vida de millones de personas. Guiados por los Principios de IA, Google está perfilando su próximo modelo, Gemini, para seguir liderando en los próximos 25 años.

¿Qué opinas sobre cómo la inteligencia artificial ha impactado en nuestra forma de comunicarnos y acceder a la información en la era digital?