El Ministerio de Ciencia, Tecnología, Conocimiento e Innovación de Chile, ha comunicado que se ha presentado un Proyecto de Ley que busca regularizar el uso de la Inteligencia Artificial (IA) en Chile, usando como referencia la Ley que fue aprobada por la Unión Europea en marzo pasado.

La ministra de Ciencia, Aisén Etcheverry comento lo siguiente, como referencia en el enfoque basado en riesgo que desarrolla el proyecto de IA que presentó el gobierno:

“No es lo mismo un algoritmo destinado a influir las emociones que uno que pretende recomendar opciones de música”.

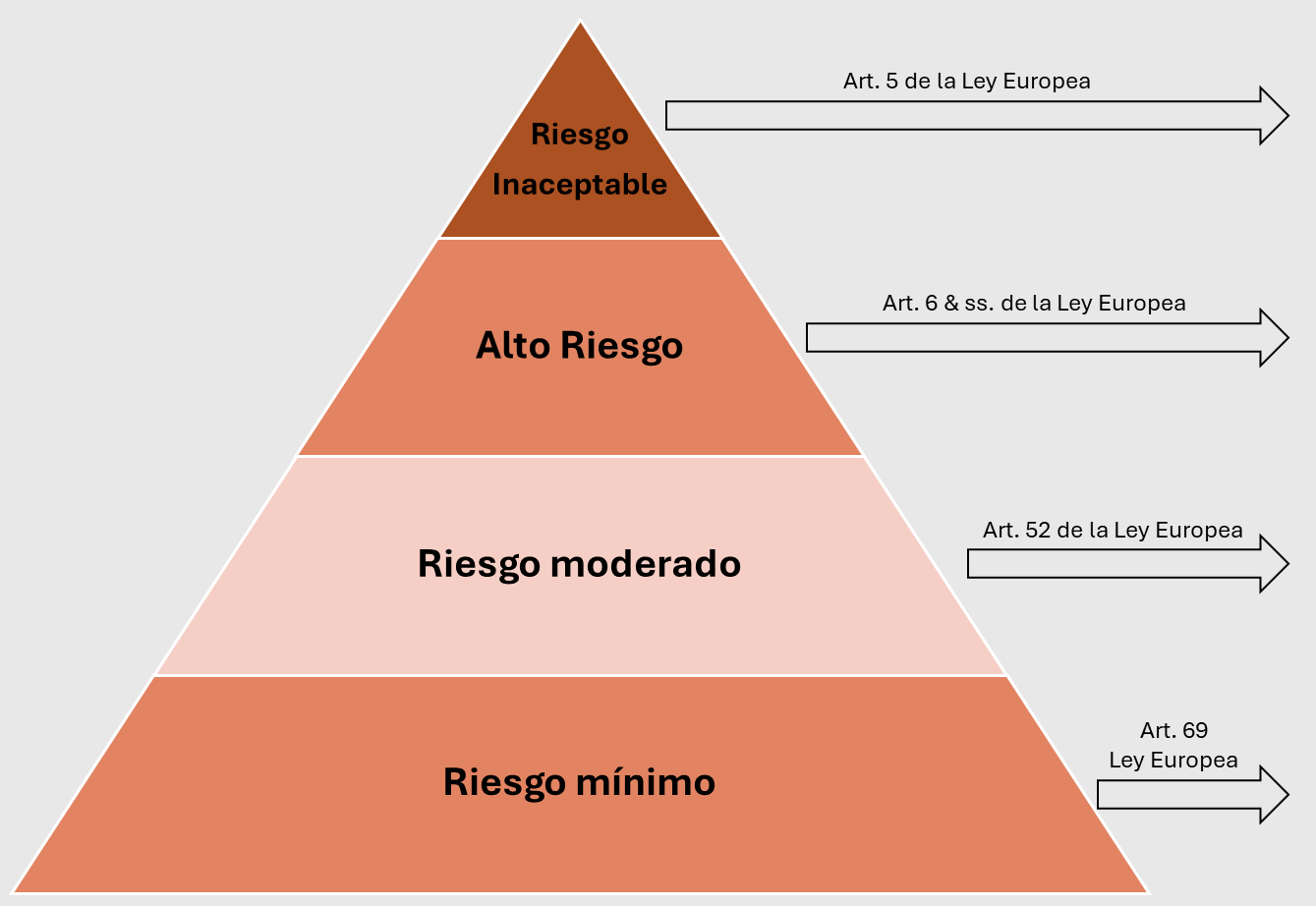

El proyecto presentado al poder legislativo, usa como referencia la Ley de IA Europea, que clasifica los sistemas en cuatro estadios:

- Riesgo inaceptable

- Alto riesgo

- Riesgo moderado o limitado.

- Riesgo mínimo, o sin incidencia evidente.

¿Qué quiere decir estas cuatro sistemas?, según detalla la ministra, las empresas con operaciones basadas en IA, deberán clasificar sus sistemas con base en un listado de procesos que estará clasificado según una matriz de riesgos:

“En lugar de exigir que las tecnologías pasen por un proceso de certificación o análisis antes de entrar al mercado, se estableció que cada empresa clasifique sus sistemas de IA en base a un listado de riesgos que se elaborará, donde cada categoría tendrá reglas específicas que cumplir. Las sanciones para quienes no lo hagan serán administrativas, aplicadas por la futura Agencia de Protección de Datos Personales, en un procedimiento regulado por ley y en el que se puede apelar en las cortes de apelaciones”.

Según explica el Ministerio, el proyecto de ley exhibe claramente las actividades que son consideradas Inaceptables, sin embargo, aquellas las categorías de Alto Riesgo y Riesgo Moderado, deberán ser consideradas/creadas por un Consejo Asesor Técnico de Inteligencia Artificial. Este equipo estaría formado por personeros de todas las áreas, incluyendo la academia, gobierno, privados y civiles.

¿Qué se define en cada categoría?

Sistemas de IA de Riesgo Inaceptable

En operaciones IA inaceptables están consideras todas aquellas tareas que puedan alterar o afectar a la dignidad de las personas, como los deepfakes. También se incluyen:

- Prácticas con alto potencial de manipulación o evaluación de los estados emocionales de una persona

- Usos biométricos para el análisis de imágenes de vídeo que empleen identificación en tiempo real (salvo para usos relacionados con la seguridad pública, tecnologías con temas terapéuticos).

- Sistemas de IA basados en técnicas de facial scraping.

- Se prohíbe ciertos sistemas de IA de calificación social genérica.

- Se prohíbe aquellos sistemas de IA destinados a la evaluación de los estados emocionales de una persona en los ámbitos que allí se especifican.

Según el proyecto de ley de IA:

"...[] los sistemas de IA de riesgo inaceptable son aquellos incompatibles con el respeto y garantía de los derechos fundamentales de las personas. Por ello, se estiman contrarios al ordenamiento jurídico nacional y se prohíbe su uso conforme prescribe el artículo 6°".

Sistemas de IA de Alto Riesgo

Entre los sistemas considerados de alto riesgo, están aquellos que pueden generar problemas en la salud, seguridad y derechos protegidos por la Constitución, entre otros. Así se define en el proyecto:

“Se describen como aquellos que presentan un riesgo significativo de causar perjuicios para la salud, la seguridad, los derechos fundamentales protegidos por la Constitución Política de la República o el medioambiente, así como los derechos de los consumidores”.

El Ministerio de Ciencias pone como ejemplo, que se utilice la IA para contratación y selección de personal, ya que este atentaría contra los derechos de las personas que postulan a trabajos.

En el proyecto también se indica que el Ministerio de Ciencias será el encargado de crear un reglamento que incluye los sistemas de IA consideradas de alto riesgo:

“...[] se deja a un reglamento dictado por el Ministerio de CTCI la lista específica de sistemas de alto riesgo, que se elaborará previa propuesta efectuada por el Consejo Asesor Técnico de IA, conforme se establece en el artículo 15°”.

Sistemas de IA de Riesgo Limitado

En este tipo de sistemas estarán clasificadas aquellas tareas de IA que no implican mayores riesgos en manipulación, engaño o error producto de la interacción con personas, así lo expone el escrito:

“...[] los sistemas de riesgo limitado como aquellos cuyo uso presenta un riesgo no significativo de manipulación, engaño o error, producto de su interacción con personas”.

Un ejemplo de esto, es el uso de lo bot para atención a clientes que responden dudas, y hoy, son ampliamente usados por muchas empresas a nivel nacional.

Por otra parte, las empresas estarán obligadas a dejar claramente escrito y de manera visibles para que las personas que interactúen con estos sistemas lo sepan. Quedan exentas de esta indicación, aquellas IA que se usen en seguridad pública:

“...[] la normativa propuesta persigue que los sistemas de IA de riesgo limitado procuren proveerse en condiciones transparentes, de modo tal que las personas sean informadas de forma clara y precisa, y les permitan estar conscientes de que están interactuando con una máquina”.

Sistemas de IA de sin Riesgo Evidente

En este estadio estarán aquellas aplicaciones que no afecten o perjudiquen directamente los derechos fundamentales de las personas, como por ejemplo: aquellas IA que recomiendan qué películas y/o canciones podrían gustarnos, en base a nuestras preferencias, tal como lo hacen hoy en día los algoritmos de Netflix y/o Spotify.

El extracto de la ley, lo puedes leer aquí.